티스토리 뷰

728x90

- 과적합(Overfitting): 하이퍼파라미터를 너무 세밀하게 조정한 경우, 모델이 학습 데이터에 지나치게 맞추어져서 일반화 능력이 떨어질 수 있다. 이로 인해 새로운 데이터에 대한 성능이 저하될 수 있다.

- 탐색 공간의 오류(Search Space Issue): 하이퍼파라미터 튜닝 시 잘못된 하이퍼파라미터 범위나 값들을 탐색할 수 있다. 예를 들어, 학습률이 너무 낮거나 높게 설정되면 최적화 과정에서 문제가 발생할 수 있다.

- 데이터의 불균형(Data Imbalance): 하이퍼파라미터 튜닝 과정에서 특정 클래스나 패턴에 대한 가중치가 과도하게 조정되어, 모델이 데이터의 일부에만 적응할 수 있다. 이로 인해 전체적인 성능이 저하될 수 있다.

- 과도한 복잡성(Too Much Complexity): 하이퍼파라미터를 조정하여 모델의 복잡도가 증가하면, 더 많은 자원이 필요하게 되고 모델이 불안정해질 수 있다. 이 경우에도 성능 저하가 발생할 수 있다.

- 랜덤성(Randomness): 하이퍼파라미터 튜닝 과정에서 무작위 요소가 개입하여 일시적으로 성능이 저하될 수 있다. 특히, 무작위 초기화나 데이터 샘플링 방법의 차이에 따라 결과가 달라질 수 있다.

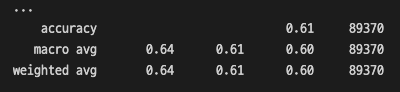

Optimized XGBoost Classification Report:

accuracy 0.75 89370

macro avg 0.77 0.75 0.75 89370

weighted avg 0.77 0.75 0.75 89370

여기서

이렇게 되었다.

과적합이거나 튜닝 과정에서의 과잉 적응 (Over-tunning) 이 된 것 같다.

정규화 , 드롭아웃 또는 교차 검증을 통해 해결해야 겠다.

728x90

'AI Development' 카테고리의 다른 글

| 모델이 학습되지 않는 이유 - loss, grad_norm, learning_rate, epoch, batch_size 정리 (0) | 2025.10.29 |

|---|---|

| LoRA 보다 풀 파인튜닝 할 때 CER 성능이 더 좋아진 이유 (0) | 2025.01.12 |

| RunPod (0) | 2025.01.03 |

250x250

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- 프론트엔드

- 이벤트유효성

- 콜백callback

- 인스턴스 옵션

- PROMISE

- 리액트 폴더구조

- 자연어처리

- 리액트

- 사용자정의이벤트

- 인스턴스 구조

- NLP

- 코랩 한글깨짐

- 컴포넌트간통신

- 이벤트에미터

- transformer

- 사전학습모델

- KoELECTRA

- 컴포넌트간데이터전달

- 코랩 워드클라우드 한글깨짐

- 로짓함수

- defaultparameter

- 코랩 워드클라우드

- async

- 인스턴스 생명주기

- 데이터옵션

- ML

- Await

- dl

- AI

- gradientclipping

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함